9 min read

Data Virtualization come Asset Strategico

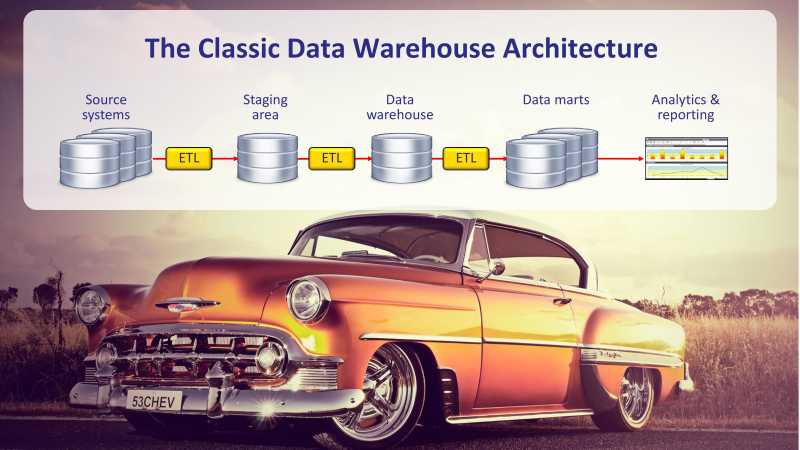

L'immagine di copertina è emblematica, forse la nascita dei data warehouse è venuta un po' dopo quel tipo di auto, ma certamente era molto tempo fa, prima di internet, del web, dei social media, e delle aziende, piccole o grandi, tutte globalizzate.

Ancora oggi i data warehouse sono al centro delle strategie di data management delle aziende, frequentemente contornati da una proliferazione di data silos e dai più articolati tool di presentation, ognuno con la sua componente di logica di business incorporata e con pretesa di essere l'unica fonte della verità, salvo poi ritrovarsi ai meeting con misure diverse per le stesse dimensioni.

![[object Object]](http://images.ctfassets.net/o53nxjrshrvi/6fCWhJYgjaFNk3ezFgDnAN/eeb432ce6e1d1d8c95f12b136389f820/silos-no-ondemand.jpg)

I Big Data ed i Data Lake

Il termine BigData è diventato di uso comune e, nell'essenza del suo significato, per tutti vuol dire (almeno): tanti, tantissmi dati.

Ora, è pur vero che oggi i dati che si producono ed archiviano sono di diversi ordini di grandezza superiori a quelli del passato, anche recente, ma ciò che è realmente cambiato è che sono fortemente cresciute le tipologie di utilizzo e di utilizzatori.

Archiviare idati nei Data Lake in formati raw, per mantenerli as-is, piuttosto che in formati strutturati o semistrutturati, sposta solo parzialmente i termini del problema vero, che è come fare il delivery. Altrimenti non si valorizza il dato archiviato.

Su questo semplice paradigma si sono incagliati molti progetti bigdata/datalake, ed è una giustificazione miope dire che gli utenti di questi dati sono solo it o data scientist, non è così: se i dati sono disponibili facilmente ed in sicurezza gli utilizzatori crescono, ed il loro valore emerge!

![[object Object]](http://images.ctfassets.net/o53nxjrshrvi/FWMtGaUhrdOaGbGjG042A/6ce0d7fc38ab7b79c899b450db9c6f24/0015.jpg)

Il Data Warehouse

Il primo effetto collaterale di questi cambiamenti, è che il classico data warehouse non basta più, troppo rigido, troppo statico, e spesso troppo costoso per i risultati che consente di ottenere

La sua struttura è adatta ad alcune tipologie di dati, soggetti ad una bassa o nulla variabilità nella loro schematizzazione, volumi modestamente elevati (rispetto ai Big Data) e importante significato storico.

Il percorcorso di deployment è impegnativo, e non può prescindere da una attenta progettazione: il rischio è che i requisiti cambino in corso d'opera, costringendo ad onerose revisioni che allungano i tempi di rilascio.

![[object Object]](http://images.ctfassets.net/o53nxjrshrvi/1FD3lud51cBTnu02TcURJu/6c69b718e2e1f5253043a086d2565a8c/0022-1.jpg)

Applicare tutte le specifiche nel mondo cablato dei data warehouse, significa gestire le ben note tre fasi, con i relativi strumenti software, dotazione hardaware e skill professonali

![[object Object]](http://images.ctfassets.net/o53nxjrshrvi/5d8rLF46KJMVqo5cqxzk0b/3c3f9acd003e7a5e2ea46a58bb5b248c/0023-1.jpg)

La virtualizzazione dei dati

La Virtualizzazione dei Dati è una tecnologia collaudata per costruire un concreto Data Fabric e facilitare Delivery e Governance dei dati, l'unica in grado di creare viste combinate di Big Data, dati Cloud, dati di streaming IoT, dai Social Media e dai sistemi legacy e data warehouse, in tempo reale, senza necessariamente spostare fisicamente alcun dato.

![[object Object]](http://images.ctfassets.net/o53nxjrshrvi/QSaNB4lUWJj2depRwzu2m/606a6fc4b188c7424db7b40eeb93d28d/0024-1.jpg)

Nella pratica significa: centralizzare le logiche di business disperse nei tool di presentazione ponendole all'interno del server(s) di virtualizzazione, con poche o nulle necessità di spostare dati per uniformare accessi, formati, semantica e policy di sicurezza.

![[object Object]](http://images.ctfassets.net/o53nxjrshrvi/2P4VV9EVFefF3UzD15HwGR/4c43432878acb4b73873432df69532d3/0030-1.jpg)

Centralizzare le logiche di business consente quindi di velocizzare lo sviluppo ed il rilascio delle viste di accesso ai dati, rendendole, per l'utente che consuma i dati, indipendenti dalla fonte da cui provengono: il layer di virtualizzazione si occupa di disaccoppiare ciò che vede l'utente da come realmente quelle informazioni vengono reperite.

Solo quando l'utente chiede i dati, il server di virtualizzazione determina il miglior modo per ottenerli (leggasi Query Optimization) e fornisce il risultato al tool di presentazione: i dati originali restano alla fonte, un altro consumatore con un altro tool di presentazione che chiede i dati della stessa vista, riceverà lo stesso risultato.

![[object Object]](http://images.ctfassets.net/o53nxjrshrvi/3NVyM7wrrIxcz4gRiifm48/ac90e7eee8aadabfca1be68fd6942bc3/0031-1.jpg)

Vi sono ulteriori benefici indotti dalla virtualizzazione dei dati, ad esempio quando si è in fase di migrazione verso soluzioni cloud, o ancor più realisticamente, quando ci si ritrova con alcune applicazioni (e relativi dati) in cloud ed altre che restano on premise, il layer di virtualizzazione diventa un armonizzatore, perchè ancora una volta consente di rendere disponibili ai consumatori le viste di dati di cui necessitano, senza che siano interessati (e vincolati) da dove fisicamente provengono.

![[object Object]](http://images.ctfassets.net/o53nxjrshrvi/CSW51sbxMRT2aE5369X3H/1f1bce4cdb014c6c2a8192bee986578a/0032-1.jpg)

La virtualizzazione dei dati risolve anche il problema di rendere disponibili ai consumatori dati freschi (leggasi provenienti dai database operazionali, o dal mondo internet) a fianco di dati che potremmo definire per semplicità "storici" (anche se vecchi solo di poche ore o del giorno prima) per garantire quella completezza di informazioni necessaria a prendere la decisione migliore, o a dare un servizio eccellente ai propri clienti.

![[object Object]](http://images.ctfassets.net/o53nxjrshrvi/aYqvDaFOfi7C0bWHLgF8p/726f676f0f4c1933aa912483be71cb5b/0033-1.jpg)

5 Key Takeaway

La quantità di dati che si produce ed archivia cresce esponenzialmente, rendendo necessario adottare nuove ed adeguate politiche per la loro gestione, ma anche e soprattutto per la loro valorizzazione

Data Warehouse, BigData, Data Lake, non sono altro che tassonomia per classificare un'unica cosa: l'archiviazione dei dati; ma evidenziano anche l'eterogeneità delle fonti che implicano nuove politiche per la governance ed il delivery

La complessità di gestione lato IT cresce, il che contribuisce ad allungare ulterioremente i progetti di delivery dei dati: va da sè che gli approcci tradizionali non bastano più

Si diversificano e moltiplicano i consumatori di dati: per insight, per prendere decisioni consapevoli, per difendersi dalle frodi, per creare algoritmi ML ed alimentarli; la disponibilità, poi, anche di dati freschi costituisce un vantaggio competitivo

La data virtualization introduce flessibilità, perchè disaccoppia le sorgenti dati, e le relative complessità di gestione, dai consumatori dei dati, ponendosi come un layer in grado di armonizzare le rispettive necessità e introducendo nel contempo governance e sicurezza

![[object Object]](http://images.ctfassets.net/o53nxjrshrvi/DDd5nLx3iNukWkD1X6vHr/f559d0e9c18d3925c23e64a0d07ef7b0/the_business_benefits_of_data_virtualization_1.png)

Scarica l'e-book The Business Benefit of Data Virtualization

![[object Object]](http://images.ctfassets.net/o53nxjrshrvi/1U05Mk8J9cVfmFdJEVT3nr/a5921912706c5eceddca588e279846a3/small_logo.png)

Drillinginfo case study

Drillinginfo è la principale società di analisi dei dati e SaaS per il supporto alle decisioni sull'esplorazione energetica, e aiuta l'industria petrolifera e del gas a ottenere risultati migliori e più rapidi. Drillinginfo fornisce assistenza a oltre 3.200 aziende in tutto il mondo dalla sede principale di Austin, in Texas.

Drillinginfo ha utilizzato la piattaforma Denodo per creare un data warehouse logico in grado di unificare senza soluzione di continuità i dati provenienti da numerose fonti strutturate e non strutturate, insieme ai dati di un tradizionale data warehouse fisico. Il data warehouse logico semplifica l'accesso a fonti moderne e legacy e consente la creazione di servizi dati che possono essere facilmente utilizzati da utenti interni ed esterni.

Drillinginfo impiegava fino a due settimane per creare servizi Web utilizzabili per lo sviluppo di applicazioni, ma con la piattaforma Denodo, l'azienda ora può costruirli in meno di un giorno. Inoltre, Drillinginfo può gestire l'intera implementazione della piattaforma Denodo con un solo sviluppatore a tempo pieno e un amministratore di virtualizzazione dei dati part-time. Tra i 20 e 30 sviluppatori interni stanno ora utilizzando i servizi dati per creare applicazioni basate sui dati, nonché un numero crescente di clienti esterni di petrolio e gas. La piattaforma Denodo ha permesso a Drillinginfo di risparmiare tempo e risorse preziose, consentendo all'azienda di accelerare il time-to-market dei prodotti dei propri clienti.

Scarica Drillinginfo case study pdf

![[object Object]](http://images.ctfassets.net/o53nxjrshrvi/jRHBaXq112lWgjhAOfqlm/e4243e528a80a9f609782c6894404c62/TransAlta-Logo.png)

TransAlta case study

TransAlta, fondata nel 1909, è cresciuta fino a diventare un produttore di energia con oltre 2300 dipendenti, circa $ 3 miliardi di entrate annue, oltre $ 9 miliardi di risorse e oltre 60 impianti di gas, idro, solare, eolico e carbone negli Stati Uniti, Canada e Australia.

La società decise di ridurre il suo footprint del data center a zero e spostare tutti i dati nel cloud, con il duplice scopo di ridurre i costi delle infrastrutture e al contempo consentire alla flessibilità di aumentare o diminuire le esigenze aziendali

Quando TransAlta ha iniziato questa transizione, l'azienda ha scoperto che non tutte le sue applicazioni potevano essere trasferite nel cloud; alcune si basavano su procedure di autenticazione sviluppate nell'ambiente locale e non potevano essere facilmente riconfigurate per consentire l'accesso al cloud. Inoltre, poiché alcuni data center erano più lontani di altri, geograficamente, hanno introdotto la latenza nel processo di migrazione.

Per facilitare la migrazione, TransAlta ha sfruttato la piattaforma Denodo per Microsoft Azure. Poiché la società utilizzava già Azure per tutte le sue soluzioni IaaS e PaaS, la distribuzione della piattaforma Denodo su Azure è stata semplice. Una volta installata, la piattaforma Denodo ha creato un livello di accesso ai dati in tempo reale tra i datacenter e il cloud. Ciò ha sottratto TransAlta dalla complessità dell'accesso ai datacenter, inclusa la distanza geografica, per facilitare una transizione senza problemi verso il cloud. Poiché la piattaforma Denodo è stata istituita come un livello centrale, ha fornito un punto centrale per la gestione dell'autenticazione, rendendo semplice l'accesso degli utenti alle applicazioni migrate.

![[object Object]](http://images.ctfassets.net/o53nxjrshrvi/20xrVrDTZ3gmhQExpVABmB/4c101ea5888b2f7e473b3135720f9bb3/Get-ligaen_logo_CMYK_gul_og_hvit.png)

"Get" case study

Get è un fornitore di telecomunicazioni norvegese con oltre un milione di clienti. Fornisce servizi a banda larga, mobili e televisivi e per anni ha distribuito contenuti televisivi utilizzando un modello di consumo lineare tradizionale.

Quando hanno iniziato a offrire contenuti on demand è subito emerso che per farlo con successo dovevano rivolgersi a ciascuno dei propri clienti individualmente.

In questo video Michael Besin, Head of Data Systems di Get, spiega che l'unico modo per raggiungere questo livello di personalizzazione era analizzare i loro dati, affrontando e risolvendo alcuni aspetti strutturali.

![[object Object]](http://images.ctfassets.net/o53nxjrshrvi/20oiLNzr2hJh7S5I5NsuUv/bea52fa2457a9eec7d148bff906e25c2/ultramobile.png)

Ultra Mobile case study

Ultra Mobile è una società di telecomunicazioni che offre servizi voce internazionali di qualità e a basso costo attraverso operatori locali. La società è cresciuta molto velocemente negli ultimi anni, ed il team IT per cercare di dare un supporto adeguato ha realizzato un data warehouse su Hadoop, ma è poi emerso che ricavarne pezzi di informazioni utili richiede skill e tempi non in grado di seguire il ritmo del business.

Il presidente Tyler Leshney ha dato al team IT 5 mesi di tempo per dotarsi di un' architettura in grado di supportare la trasformazione dell'azienda in una "data driven organization".

Il team di BI ha definito tre necessità principali da soddisfare:

stabilire un livello di governance in grado di rendere disponibile agli utenti di business un modello dati unificato e dai contenuti comprensibili perchè semanticamente a loro affini, superando la confusione della situazione "a silos" dei dati, nella quale non era mai chiaro quale regola di business fosse stata applicata;

consentire adeguati ruoli di accesso ai dati tra quelli di provenienza operativa e quelli storicizzati sul data leake Cloudera;

accelerare le prestazioni delle query sul data lake, per consentire di fornire agli utilizzatori nuove e più fruibili dashboard.